プライバシー保護連合学習技術 DeepProtect

印刷する

印刷する

特徴・優位性

- 複数の組織が持つデータセットを互いに秘匿したまま深層学習が可能

- 複数組織の連携により、不正取引等をリアルタイムに検知

用途・応用分野

- 金融・保険、医療、自治体、製造・販売業等の幅広い分野において、データを保護し効率的に運用

概要

AIを活用したサービスやシステムが高いパフォーマンスを発揮するには、大量の学習用データを集めることが必要になりますが、学習用データの内容によっては、単一の企業や組織では十分なデータを集められず、高い精度を持った学習モデルを作成することが難しくなります。

一方で、複数の組織が共同でデータを集めて学習モデルを作成する場合には、個人情報や企業の非公開情報などの機密性の高いデータの扱いが課題になり、データの適切な保護や、個人情報保護法等の法令やガイドラインの遵守に対応する必要があります。

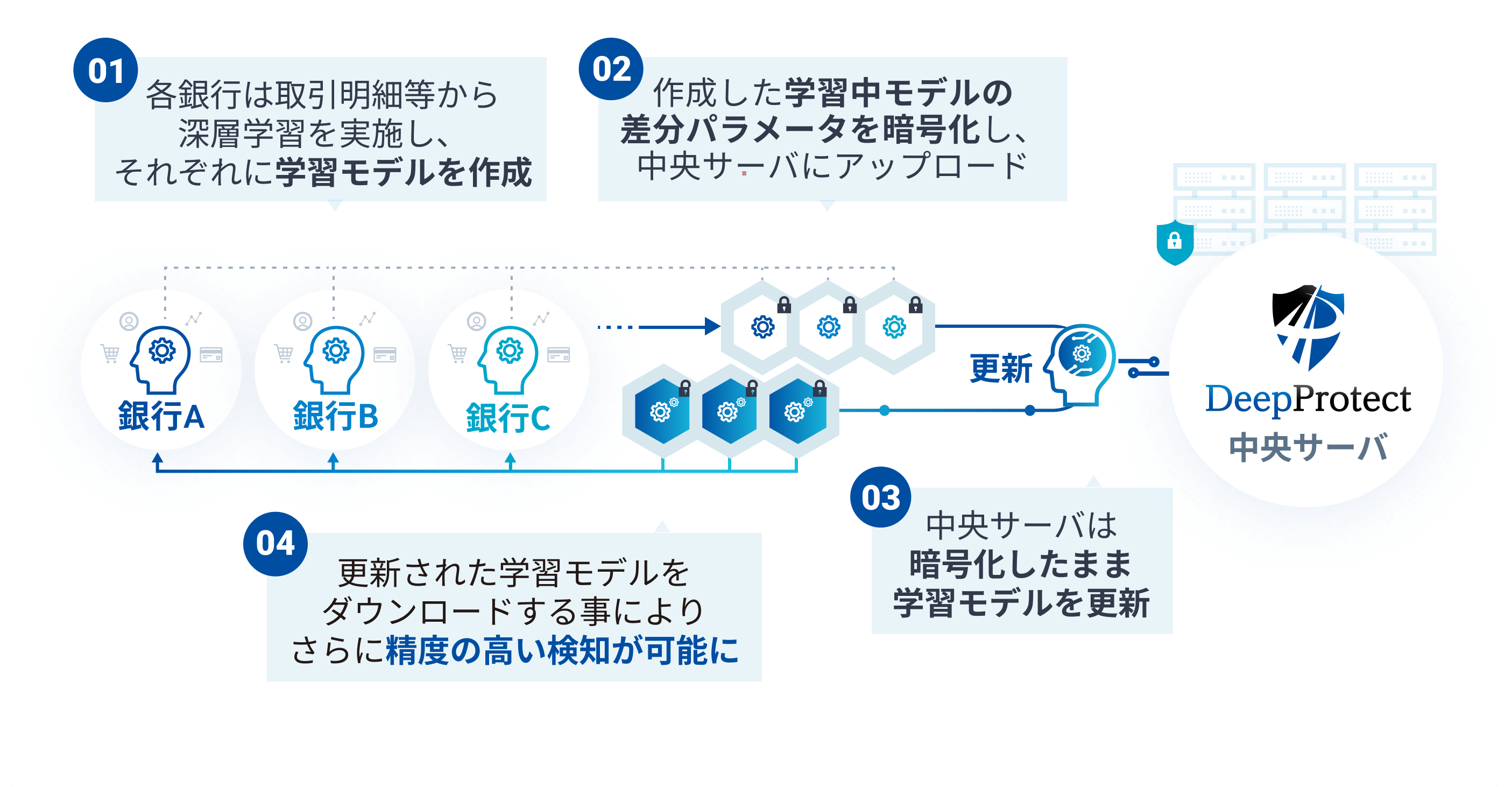

このような複数組織で連携するデータ解析における課題を解決するのがプライバシー保護連合学習技術『DeepProtect』です。 DeepProtectは、連合学習(Federated Learning)という機械学習の手法に暗号技術を融合して実現したNICTの独自のプライバシー保護技術で、複数の組織が持つデータセットを互いに秘匿し、プライバシーや機密性を保ったままに共同で深層学習を行うことを可能にします。

本技術はこれまで、金融機関と共同で不正送金検知等の実証実験に取り組んできました。現在は主に技術移転先を通じて技術のご提供を行っています。

適用先は金融関連に限らず、データ漏えいやプライバシーの懸念からデータ共有が困難である様々な分野への応用が可能です。複数の組織で連携して深層学習を行うことで、調査精度の向上や今まで⾒つからなかった知見の獲得が期待できます。 (2025年6月19日更新)

※JST戦略的創造研究推進事業 AIP加速課題の研究課題「秘匿計算による安全な組織間データ連携技術の社会実装(JPMJCR22U5)」の支援により実施されました。

プライバシー保護連合学習技術 DeepProtect

関連情報

- 公式サイト:「DeepProtect」公式サイト

- プレスリリース:

- 紹介動画:『NICTステーション~DeepProtect~(NICTchannel)』

- 公式サイト:「DeepProtect」公式サイト(https://deepprotect.nict.go.jp/)

- プレスリリース:

- 2025.06.10. プライバシー保護連合学習技術「DeepProtect」を活用した銀行の不正口座検知の実証実験を実施し、検知精度向上を確認(https://www.nict.go.jp/press/2025/06/10-1.html)

- 2022.03.17. プライバシー保護連合学習技術「DeepProtect」を技術移転(https://www.nict.go.jp/press/2022/03/17-1.html)

- 2022.03.10.プライバシー保護連合学習技術を活用した不正送金検知の実証実験を実施(https://www.nict.go.jp/press/2022/03/10-1.html)

- 紹介動画:『NICTステーション~DeepProtect~(NICTchannel)』(https://youtu.be/CpA9OD5vUIM)

担当部門

サイバーセキュリティ研究所 セキュリティ基盤研究室(https://sfl.nict.go.jp/)